基于示教与自主学习的机器人类人技能学习关键技术研究

项目介绍

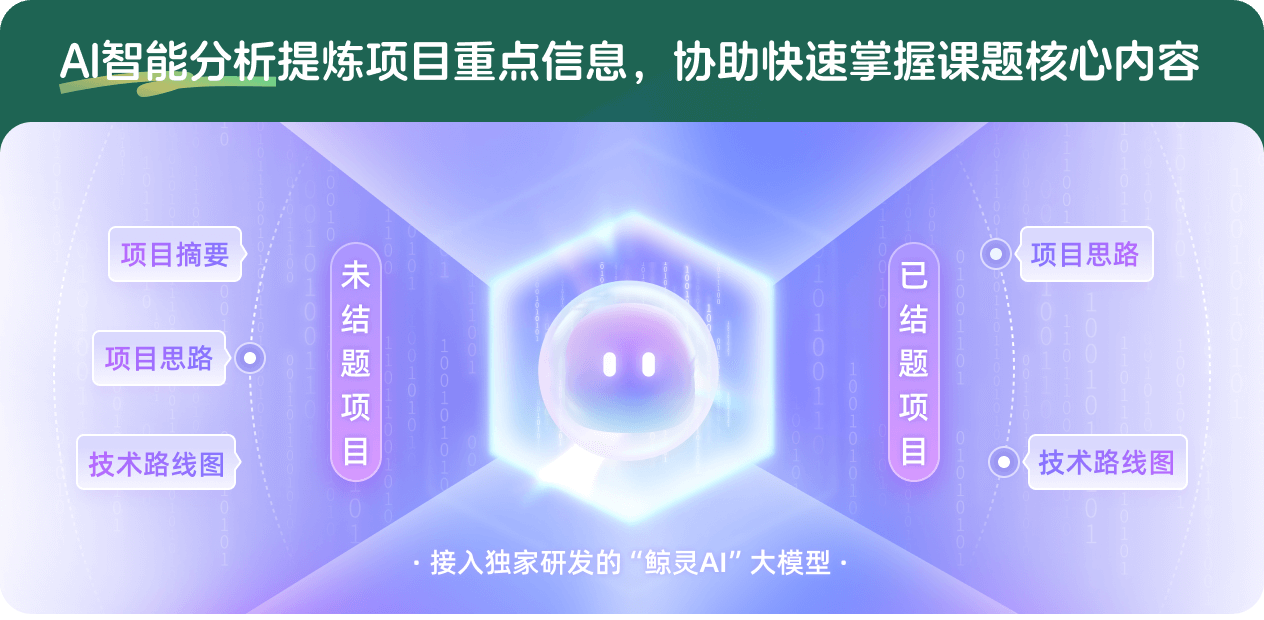

AI项目解读

基本信息

- 批准号:61906123

- 项目类别:青年科学基金项目

- 资助金额:24.0万

- 负责人:

- 依托单位:

- 学科分类:F0608.智能系统与人工智能安全

- 结题年份:2022

- 批准年份:2019

- 项目状态:已结题

- 起止时间:2020-01-01 至2022-12-31

- 项目参与者:--

- 关键词:

项目摘要

As the task for the robot become more complicated, manually robot programming is more time consuming and inconvenient. The robot should be capable of learning using supervised and reinforcement learning like human. Traditional methods only employ single learning method, have not achieved improvement through combination of different learning approaches. The topic is to analyze the way how human-being learn skills and use the idea on the robot skill learning tasks. This work intents to combine different skill learning methods to take full advantages of each one. The reinforcement learning algorithm is initialized using the policies learned from demonstrations, then deep learning method is used to enable the reinforcement learning algorithm with the capability of generalization. It also helps to solve the dimension curse problem. The proposed algorithm can save lots of time and effort during updating the robot with new skills.

随着机器人与人类工作和生活联系的日趋紧密,使机器人完成复杂任务的需求愈加迫切。以手动编程的方式增加机器人功能的做法不仅任务日益繁重且往往难以满足不断变化的新需求,迫切需要机器人像人类同时具备模仿和自主学习的能力。目前的技能学习技术往往是单一的方法,未能建立不同学习方法之间的联系,无法充分利用不同方法实现优势互补,因此面对不同场景复杂变化的任务常常难以为计。本课题将在前期研究积累基础上,深入分析人类技能学习机理,以示教学习和强化学习为研究对象,研究将二者有机的结合机制,有效利用不同学习方法实现优势互补。拟提出一种基于示教学习和强化学习的机器人类人技能学习框架,该框架不仅可以利用于仿真环境学习,还支持机器人通过与实际环境交互进行学习。该框架可以有效提高机器人自主学习复杂任务的能力,同时大大节约机器人技能更新的工作量。本课题研究是对现有研究难点和不足的一种创新性探索。

结项摘要

近些年来,制造业不断增长的个性化制造需求让“小批量、多品种”的产品模式成为一种新常态,尤其是劳动力密集型行业。这使得机器人的作业环境日趋多变,任务的复杂性、操作的灵巧性不断增加。示教学习作为机器人技能学习的一种重要手段,允许用户利用非编程的方式,快速的将任务展示给机器人,大大降低了技能展示的门槛。而要将示教过程中蕴含的技能有效的提取出来,需要设计相应的示教解析算法。. 示教解析中的重要任务之一是识别示教中的动作信息,本项目围绕这一重要问题,研究对示教中的操作类动作以及非操作类动作进行有效识别的方法。研究过程中,首先,提出了基于多通道深度学习模型的动作识别算法,该方法利用三通道动作历史图提取全局动作信息,利用骨骼点信息捕捉局部空间和时序特征,最后将物体-动作先验知识融入到识别模型中,以提升模型性能。实验结果表明该模型可有效识别人体动作。此外,与日常动作相比较,识别操作动作难度更大。原因在于一些操作类动作仅包含细微的关节动作,难以用视觉传感器捕捉。因此,为了解决这个问题,在视觉传感器的基础上,我们又增加了力传感器捕捉作用力并通过光学捕捉系统建立手指关节模型以获取手指运动信息,依次来全方位捕捉操作动作信息。利用同步机制将不同类型的传感器数据进行同步,然后分别设计了特征层融合机制及决策层融合机制模型,对操作动作加以有效识别。实验结果表明该模型可以有效识别7类操作类动作。最后,我们搭建了基于素描任务的机器人技能学习示范。利用深度学习模型,学习人脸的素描特征,然后设计了高效的路径规划算法,使得素描机器人可在短时间内完成素描任务。

项目成果

期刊论文数量(3)

专著数量(0)

科研奖励数量(0)

会议论文数量(0)

专利数量(1)

Multiple stream deep learning model for human action recognition

用于人类动作识别的多流深度学习模型

- DOI:--

- 发表时间:2020

- 期刊:Image and Vision Computing

- 影响因子:4.7

- 作者:Ye Gu;Xiaofenng Ye;Weihua Sheng;Yongsheng Ou;Yongqiang Li

- 通讯作者:Yongqiang Li

Sensor fusion based manipulative action recognition

基于传感器融合的操纵动作识别

- DOI:--

- 发表时间:2021

- 期刊:Autonomous Robots

- 影响因子:3.5

- 作者:Ye Gu;Meiqin Liu;Weihua Sheng;Yongsheng Ou;Yongqiang Li

- 通讯作者:Yongqiang Li

Humanoid Robot Portrait Drawing Based on Deep Learning Techniques and Efficient Path Planning

基于深度学习技术和高效路径规划的仿人机器人肖像绘制

- DOI:10.1080/21505594.2018.1482180

- 发表时间:2018

- 期刊:Arabian Journal for Science and Engineering

- 影响因子:2.9

- 作者:Lamb LE;Siggins MK;Scudamore C;Macdonald W;Turner CE;Lynskey NN;Tan LKK;Sriskandan S

- 通讯作者:Sriskandan S

数据更新时间:{{ journalArticles.updateTime }}

{{

item.title }}

{{ item.translation_title }}

- DOI:{{ item.doi || "--"}}

- 发表时间:{{ item.publish_year || "--" }}

- 期刊:{{ item.journal_name }}

- 影响因子:{{ item.factor || "--"}}

- 作者:{{ item.authors }}

- 通讯作者:{{ item.author }}

数据更新时间:{{ journalArticles.updateTime }}

{{ item.title }}

- 作者:{{ item.authors }}

数据更新时间:{{ monograph.updateTime }}

{{ item.title }}

- 作者:{{ item.authors }}

数据更新时间:{{ sciAawards.updateTime }}

{{ item.title }}

- 作者:{{ item.authors }}

数据更新时间:{{ conferencePapers.updateTime }}

{{ item.title }}

- 作者:{{ item.authors }}

数据更新时间:{{ patent.updateTime }}

其他文献

其他文献

{{

item.title }}

{{ item.translation_title }}

- DOI:{{ item.doi || "--" }}

- 发表时间:{{ item.publish_year || "--"}}

- 期刊:{{ item.journal_name }}

- 影响因子:{{ item.factor || "--" }}

- 作者:{{ item.authors }}

- 通讯作者:{{ item.author }}

内容获取失败,请点击重试

查看分析示例

此项目为已结题,我已根据课题信息分析并撰写以下内容,帮您拓宽课题思路:

AI项目摘要

AI项目思路

AI技术路线图

请为本次AI项目解读的内容对您的实用性打分

非常不实用

非常实用

1

2

3

4

5

6

7

8

9

10

您认为此功能如何分析更能满足您的需求,请填写您的反馈:

相似国自然基金

{{ item.name }}

- 批准号:{{ item.ratify_no }}

- 批准年份:{{ item.approval_year }}

- 资助金额:{{ item.support_num }}

- 项目类别:{{ item.project_type }}

相似海外基金

{{

item.name }}

{{ item.translate_name }}

- 批准号:{{ item.ratify_no }}

- 财政年份:{{ item.approval_year }}

- 资助金额:{{ item.support_num }}

- 项目类别:{{ item.project_type }}